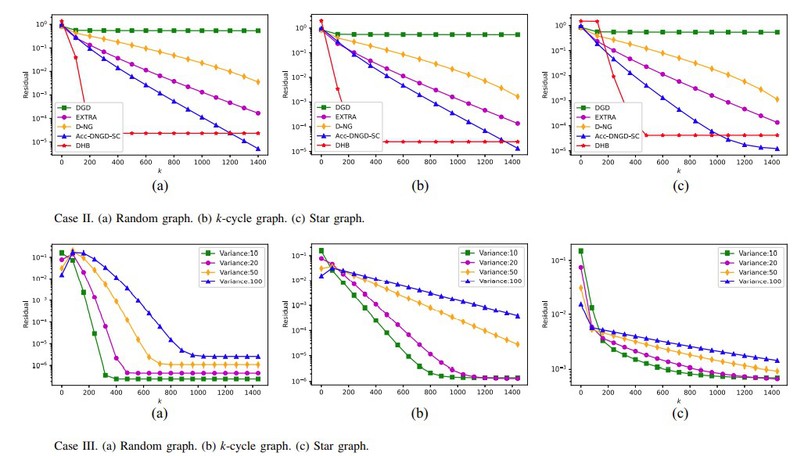

人工智能、大数据以及机器学习的蓬勃发展给人类生产生活带来极大便利的同时,也给其背后依靠的重要技术-分布式优化,带来了巨大的挑战。如:如何对分布式优化算法进行加速?如何提供简洁有效的收敛性分析工具?如何给出算法收敛速度的显式表达式?针对这些挑战性问题,我们提出了具有历史状态信息的一阶分布式优化算法,达到了简单且快速提升收敛速度的效果。相关论文“Convergence Analysis of Distributed Gradient Gescent Algorithms with One and Two Momentum Terms”已在IEEE TCYB(IF 19.1)在线发表, DOI:10.1109/TCYB.2022. 3218663。刘兵副教授为第一作者,柴利教授和易静文副教授为共同通讯作者。